En el mundo literario y artístico, la preocupación por los aspectos éticos de la relación entre el ser humano y sus propias creaciones siempre ha estado presente. La ciencia ficción nos deja múltiples pruebas de ello. Si es usted fan de ese género, recordará, probablemente, las famosas tres leyes de la robótica que acuñó el escritor Isaac Asimov. Viajando hacia lo desconocido. La primera de ellas rezaba: “Un robot no hará daño a un ser humano ni, por inacción, permitirá que un ser humano sufra daño”. Probablemente uno de los primeros intentos, aunque fuera literario, de hablar de un código ético aplicado a la tecnología.

En el mundo literario y artístico, la preocupación por los aspectos éticos de la relación entre el ser humano y sus propias creaciones siempre ha estado presente. La ciencia ficción nos deja múltiples pruebas de ello. Si es usted fan de ese género, recordará, probablemente, las famosas tres leyes de la robótica que acuñó el escritor Isaac Asimov. Viajando hacia lo desconocido. La primera de ellas rezaba: “Un robot no hará daño a un ser humano ni, por inacción, permitirá que un ser humano sufra daño”. Probablemente uno de los primeros intentos, aunque fuera literario, de hablar de un código ético aplicado a la tecnología.

Dr. Marcos Eguiguren. Director Management, Law, Society and Humanities Department. Co-fundador de SingularNet Consulting.

Una de las mejores muestras de los dilemas hombre-máquina es la que refleja la película 2001, una odisea espacial, dirigida en 1968 por Stanley Kubrick, y con una novela del mismo título, escrita en paralelo a la filmación de la película, por otro de los iconos de la ciencia ficción, Arthur C. Clarke. En esa historia, uno de los principales protagonistas es HAL9000, el súper ordenador de Inteligencia Artificial (IA) que dirige y controla una nave que debe acercar a un grupo de científicos y astronautas a una base lunar. Las extrañas decisiones de Hal, como le llamaban en sus conversaciones con el ordenador los propios astronautas, acaban provocando la muerte de algunos de ellos y el fracaso de la misión.

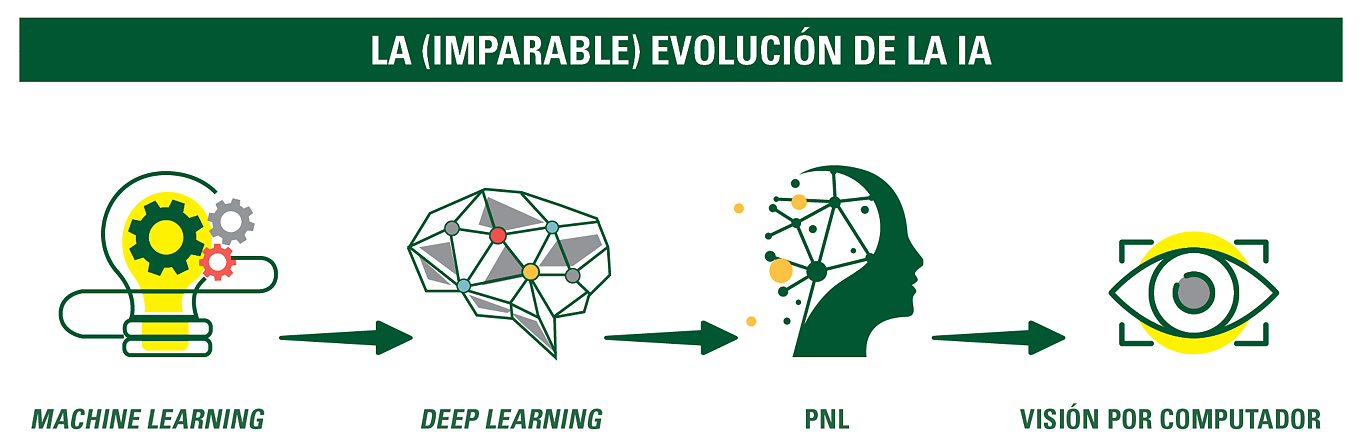

![]() Hoy, a diferencia de Asimov, Clarke o Kubrick en las décadas de los cincuenta o sesenta del siglo pasado, ya no hablamos de ciencia ficción. La inteligencia artificial lleva entre nosotros algunos años, y está aquí para quedarse y para hacerse cada vez más sofisticada y compleja. La evolución de la IA es imparable. Los modelos de machine learning utilizan algoritmos matemáticos que recrean árboles de decisión y permiten que las máquinas aprendan. Ese modelo está evolucionando hacia el deep learning que, utilizando algoritmos distintos y más sofisticados, permite que los sistemas y las máquinas puedan aprender en formato red neuronal, de forma similar al tipo de conexiones biológicas que se da en el cerebro humano. A todo ello hay que sumarle las técnicas de procesamiento del lenguaje natural (PNL) y la visión por computador. La combinación de esas cuatro grandes categorías de IA sitúa a la humanidad a las puertas de nuevas y enormes posibilidades de desarrollo, pero, también, ante un mayúsculo desafío ético.

Hoy, a diferencia de Asimov, Clarke o Kubrick en las décadas de los cincuenta o sesenta del siglo pasado, ya no hablamos de ciencia ficción. La inteligencia artificial lleva entre nosotros algunos años, y está aquí para quedarse y para hacerse cada vez más sofisticada y compleja. La evolución de la IA es imparable. Los modelos de machine learning utilizan algoritmos matemáticos que recrean árboles de decisión y permiten que las máquinas aprendan. Ese modelo está evolucionando hacia el deep learning que, utilizando algoritmos distintos y más sofisticados, permite que los sistemas y las máquinas puedan aprender en formato red neuronal, de forma similar al tipo de conexiones biológicas que se da en el cerebro humano. A todo ello hay que sumarle las técnicas de procesamiento del lenguaje natural (PNL) y la visión por computador. La combinación de esas cuatro grandes categorías de IA sitúa a la humanidad a las puertas de nuevas y enormes posibilidades de desarrollo, pero, también, ante un mayúsculo desafío ético.

Simplificando al máximo, la ética es la disciplina que trata de lo que es bueno y de lo que es malo, y cuando nos referimos a ella desde la perspectiva empresarial, no solo hablamos de lo que es bueno para el negocio, sino de lo que es bueno para las comunidades, stakeholders, en los que opera una empresa. Cuando hablamos de las empresas que diseñan y producen IA, deben regir en ellas, para todo el ciclo de vida de la misma —investigación, diseño, programación, construcción, operación y monitoreo—, los mismos criterios éticos que se aplican a la actividad humana. La IA, en todas sus facetas, debe respetar el human and planetary wellbeing.

La IA, en todas sus facetas, debe respetar el human and planetary wellbeing

EL PAPEL CLAVE DE DIRECTIVOS E INGENIEROS

Desde luego se ha escrito mucho sobre este particular, pero, sin duda porque surge del mundo de los propios ingenieros a nivel internacional, es especialmente relevante el documento The IEEE Global Initiative on Ethics of Autonomous and Intelligent Systems, lanzado por el Instituto de ingeniería eléctrica y electrónica (IEEE, por sus siglas en inglés). En esa publicación se propone un Ethically Aligned Design (diseño alineado éticamente) basado en valores humanos universales, se reconoce la necesidad de la creación de estándares ético-técnicos, e incluso se apunta la posibilidad de la creación de organismos certificadores.

![]() Los propios principios de ese “diseño alineado éticamente” son una adaptación de los que encontraríamos en otras ramas de la actividad humana: derechos humanos, bienestar humano, eficacia, transparencia, responsabilidad, concienciación sobre el uso indebido y riesgos de la IA, agencia independiente para mantener la capacidad de la persona para tener control sobre su identidad y, finalmente, competencia para un funcionamiento seguro y eficaz de la IA.

Los propios principios de ese “diseño alineado éticamente” son una adaptación de los que encontraríamos en otras ramas de la actividad humana: derechos humanos, bienestar humano, eficacia, transparencia, responsabilidad, concienciación sobre el uso indebido y riesgos de la IA, agencia independiente para mantener la capacidad de la persona para tener control sobre su identidad y, finalmente, competencia para un funcionamiento seguro y eficaz de la IA.

Es curioso que sea el propio documento del IEEE, y no las instituciones públicas, quien sugiere abrir la posibilidad de ofrecer educación sobre ética y seguridad para sensibilizar a la sociedad en general sobre los múltiples riesgos potenciales derivados de un uso inadecuado de la IA.

En cualquier caso, la aparición de principios éticos que afectan al desarrollo de la IA sitúa a las profesiones relacionadas con la misma, muy en especial a los diversos tipos de ingenierías, igual que ya ha pasado con muchas otras profesiones en el pasado, ante un escenario de deber fiduciario. Pero, lógicamente, ese escenario de deber fiduciario, también afecta de forma directa a la alta dirección y a los consejos y órganos de gobernanza de todo tipo de empresas tecnológicas con capacidad para crear IA.

REGULAR, SÍ, PERO SIN ENCORSETAR

No solamente hace falta tener unos principios éticos claros, sino que tarde o temprano, la legislación tendrá que aclarar cuáles son las cuestiones básicas de responsabilidad que afectan al desarrollo de la IA a lo largo de todas sus fases de vida. Todos los implicados han de conocer sus derechos y obligaciones. Es cierto que la aplicación de principios diferentes en las diferentes grandes áreas económicas del mundo, China, EE. UU. y la UE, por citar las tres principales, darían probablemente lugar a regulaciones distintas; sin embargo, sería conveniente intentar llegar a acuerdos globales, por lo menos en una serie de principios mínimos, para que no se den dificultades en la implementación posterior de las iniciativas de IA en ciertos países.

En el caso de Europa, cuando llegue el momento de legislar y regular al respecto, habría que exigirle a la UE que, de una vez por todas, lo haga de una manera sensata y abierta, que permita una regulación flexible, suficiente para una protección inteligente de los usuarios, basada en principios comúnmente aceptados, pero que no se convierta en un corsé ininteligible que dificulte la innovación en IA y que acabe agrandando la diferencia de desarrollo que, en este campo, ya existe entre las empresas líderes en otras zonas del planeta y las de la Unión Europea.

No podemos olvidar que la transparencia acaba convirtiéndose en un facto higiénico que facilita e impulsa conductas éticas. El sector de la IA no es ajeno a ese hecho

POR UNA IA SIN LETRA PEQUEÑA

Como en todas las actividades humanas, tanto públicas como privadas, la utilización de principios éticos comúnmente aceptados es imprescindible para un desarrollo harmónico y respetuoso de la Inteligencia Artificial, de las muchas iniciativas y servicios que ya están en marcha hoy y, sobre todo, de las muchísimas novedades que veremos en los próximos años.

Los altos directivos y los órganos de administración de las compañías implicadas en su desarrollo y, por descontado, la profesión de ingeniero en su concepción más amplia, deben abrazar claros principios éticos y, sobre todo, actuar con total transparencia en las diversas fases de implementación de las iniciativas en IA. No podemos olvidar que la transparencia acaba convirtiéndose en un facto higiénico que facilita e impulsa conductas éticas. El sector de la IA no es ajeno a ese hecho.

No hace falta que recurramos a la ciencia ficción para adivinar los peligros que pueden derivarse de una implementación inadecuada de la IA. Ya estamos observando, hoy en día, lo que puede ocurrir cuando no hay un respeto mayúsculo por la privacidad o cuando determinados algoritmos imponen sesgos inadecuados en las recomendaciones de ciertos programas. Estamos a tiempo para evitar un mundo en el que tengamos que sufrir los desvaríos de nuevos HAL9000.