A la literatura i a l’art, hi podem trobar diverses referències sobre els aspectes ètics de la relació entre l’ésser humà i les seves pròpies creacions. La ciència ficció ens en deixa múltiples proves. Si vostè és seguidor d’aquest gènere, recordarà, probablement, les famoses tres lleis de la robòtica que va encunyar l’escriptor Isaac Asimov. La primera d’elles resava: “Un robot no farà mal a un ésser humà ni, per inacció, permetrà que un ésser humà prengui mal.” Probablement un dels primers intents, encara que fos literari, de parlar d’un codi ètic aplicat a la tecnologia.

A la literatura i a l’art, hi podem trobar diverses referències sobre els aspectes ètics de la relació entre l’ésser humà i les seves pròpies creacions. La ciència ficció ens en deixa múltiples proves. Si vostè és seguidor d’aquest gènere, recordarà, probablement, les famoses tres lleis de la robòtica que va encunyar l’escriptor Isaac Asimov. La primera d’elles resava: “Un robot no farà mal a un ésser humà ni, per inacció, permetrà que un ésser humà prengui mal.” Probablement un dels primers intents, encara que fos literari, de parlar d’un codi ètic aplicat a la tecnologia.

Dr. Marcos Eguiguren. Director Management, Law, Society and Humanities Department. Co-fundador de SingularNet Consulting.

Una de les millors mostres dels dilemes home-màquina és la que reflecteix la pel·lícula 2001, una odissea de l’espai, dirigida el 1968 per Stanley Kubrick, que compta amb una novel·la amb el mateix títol, escrita en paral·lel a la filmació de la pel·lícula, per una altra de les icones de la ciència ficció, Arthur C. Clarke. En aquesta història, un dels principals protagonistes és HAL9000, el súper ordinador d’Intel·ligència Artificial (IA) que dirigeix i controla una nau que ha d’apropar un grup de científics i astronautes a una base lunar. Les estranyes decisions de Hal, tal com l’anomenen els propis astronautes en les seves converses amb l’ordinador, acaben provocant la mort d’alguns d’ells i el fracàs de la missió.

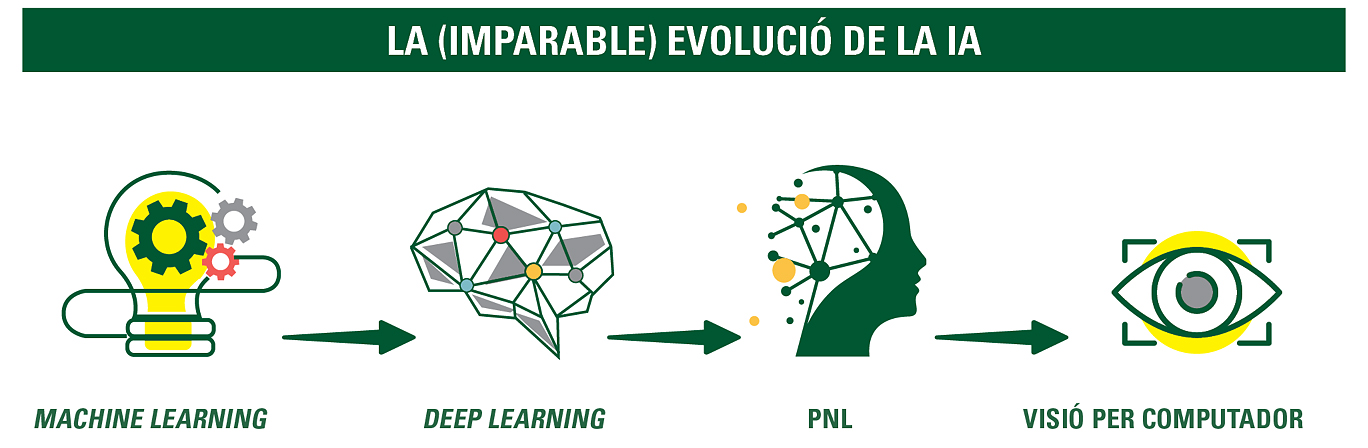

![]() Avui, a diferència d’Asimov, Clarke o Kubrick en les dècades dels anys cinquanta o seixanta del segle passat, ja no parlem de ciència ficció. La Intel·ligència Artificial és amb nosaltres des de ja fa uns quants anys, i és aquí per quedar-se i per fer-se cada vegada més sofisticada i complexa. L’evolució de la IA és imparable. Els models de machine learning utilitzen algoritmes matemàtics que recreen arbres de decisió i permeten que les màquines aprenguin. Aquest model està evolucionant cap al deep learning que, utilitzant algoritmes diferents i més sofisticats, permet que els sistemes i les màquines puguin aprendre en format de xarxa neuronal, de manera similar al tipus de connexions biològiques que succeeixen en el cervell humà. A tot això cal sumar-hi les tècniques de processament de llenguatge natural (PNL) i la visió per computador. La combinació d’aquestes quatre grans categories d’IA situa la humanitat a les portes de noves i enormes possibilitats de desenvolupament, però, també, davant d’un desafiament ètic majúscul.

Avui, a diferència d’Asimov, Clarke o Kubrick en les dècades dels anys cinquanta o seixanta del segle passat, ja no parlem de ciència ficció. La Intel·ligència Artificial és amb nosaltres des de ja fa uns quants anys, i és aquí per quedar-se i per fer-se cada vegada més sofisticada i complexa. L’evolució de la IA és imparable. Els models de machine learning utilitzen algoritmes matemàtics que recreen arbres de decisió i permeten que les màquines aprenguin. Aquest model està evolucionant cap al deep learning que, utilitzant algoritmes diferents i més sofisticats, permet que els sistemes i les màquines puguin aprendre en format de xarxa neuronal, de manera similar al tipus de connexions biològiques que succeeixen en el cervell humà. A tot això cal sumar-hi les tècniques de processament de llenguatge natural (PNL) i la visió per computador. La combinació d’aquestes quatre grans categories d’IA situa la humanitat a les portes de noves i enormes possibilitats de desenvolupament, però, també, davant d’un desafiament ètic majúscul.

Simplificant al màxim, l’ètica és la disciplina que tracta d’allò que és bo i del que és dolent, i quan ens referim a ella des de la perspectiva empresarial, no només parlem del que és bo per al negoci, sinó del que és bo per a les comunitats, stakeholders, en els quals opera una empresa. Quan parlem de les empreses que dissenyen i produeixen IA, hi han de regir, per a tot el seu cicle de vida —investigació, disseny, programació, construcció, operació i monitoratge—, els mateixos criteris ètics que s’apliquen a l’activitat humana. La IA, en totes les seves facetes, ha de respectar el human and planetary wellbeing.

La IA, en totes les seves facetes, ha de respectar el human and planetary wellbeing

GOVERNANÇA: EL PAPER CLAU DE DIRECTIUS I ENGINYERS

Per descomptat, s’ha escrit molt sobre aquest particular, però, sens dubte perquè sorgeix del món dels propis enginyers a nivell internacional, és especialment rellevant el document The IEEE Global Initiative on Ethics of Autonomous and Intelligent Systems, llançat per l’Institut d’enginyeria elèctrica i electrònica (IEEE, per les sigles en anglès). En aquesta publicació es proposa un Ethically aligned Design (disseny alineat èticament) basat en valors humans universals, i s’hi reconeix la necessitat de la creació d’estàndards ètico-tècnics, i fins i tot s’apunta la possibilitat de la creació d’organismes certificadors.

![]() Els mateixos principis d’aquest “disseny alineat èticament” són una adaptació dels que trobaríem en altres branques de l’activitat humana: drets humans, benestar humà, eficàcia, transparència, responsabilitat, conscienciació sobre l’ús indegut i els riscos de la IA, agència independent per mantenir la capacitat de la persona per tenir control sobre la seva identitat i, finalment, competència per a un funcionament segur i eficaç de la IA.

Els mateixos principis d’aquest “disseny alineat èticament” són una adaptació dels que trobaríem en altres branques de l’activitat humana: drets humans, benestar humà, eficàcia, transparència, responsabilitat, conscienciació sobre l’ús indegut i els riscos de la IA, agència independent per mantenir la capacitat de la persona per tenir control sobre la seva identitat i, finalment, competència per a un funcionament segur i eficaç de la IA.

És curiós que sigui el mateix document de l’IEEE, i no les institucions públiques, qui suggereix obrir la possibilitat d’oferir educació sobre ètica i seguretat per sensibilitzar la societat, en general, sobre els múltiples riscos potencials derivats d’un ús inadequat de la IA.

En qualsevol cas, l’aparició de principis ètics que afecten el desenvolupament de la IA situa les professions que hi estan relacionades —molt especialment els diversos tipus d’enginyeries, igual com ja ha passat amb moltes altres professions en el passat— davant d’un escenari de deure fiduciari. Però, lògicament, aquest escenari de deure fiduciari també afecta de manera directa l’alta direcció i els consells i òrgans de governança de tot tipus d’empreses tecnològiques amb capacitat per crear IA.

REGULAR, SÍ, PERÒ SENSE ENCOTILLAR

No solament cal tenir uns principis ètics clars, sinó que tard o d’hora, la legislació haurà d’aclarir quines són les qüestions bàsiques de responsabilitat que afecten el desenvolupament de la IA al llarg de totes les seves fases de vida. Tots els implicats han de conèixer els seus drets i les seves obligacions. És cert que l’aplicació de principis diferents en les diferents grans àrees econòmiques del món —la Xina, els EUA i la UE, per citar les tres principals— donarien probablement lloc a regulacions diferents; però, seria convenient intentar arribar a acords globals, almenys en una sèrie de principis mínims, perquè no hi hagi dificultats en la implementació posterior de les iniciatives d’IA en certs països.

En el cas d’Europa, quan arribi el moment de legislar i regular al respecte, caldria exigir-li a la UE que, d’una vegada per totes, ho faci d’una manera assenyada i oberta, que permeti una regulació flexible, suficient per a una protecció intel·ligent dels usuaris, basada en principis comunament acceptats, però que no es converteixi en una cotilla inintel·ligible que dificulti la innovació en IA i que acabi engrandint la diferència de desenvolupament que, en aquest camp, ja hi ha entre les empreses líders en altres zones del planeta i les de la Unió Europea.

No podem oblidar que la transparència acaba esdevenint un factor higiènic que facilita i impulsa conductes ètiques. El sector de la IA no hi és aliè

PER UNA IA SENSE LLETRA PETITA

Com succeeix en totes les activitats humanes, tant públiques com privades, la utilització de principis ètics comunament acceptats és imprescindible per a un desenvolupament harmònic i respectuós de la Intel·ligència Artificial, de les moltes iniciatives i serveis que ja estan en marxa avui i, sobretot, de les moltíssimes novetats que veurem en els propers anys.

Els alts directius i els òrgans d’administració de les companyies implicades en el seu desenvolupament i, per descomptat, la professió d’enginyer en la seva concepció més àmplia, han d’abraçar clars principis ètics i, sobretot, actuar amb total transparència en les diverses fases d’implementació de les iniciatives en IA. No podem oblidar que la transparència acaba esdevenint un factor higiènic que facilita i impulsa conductes ètiques. El sector de la IA no hi és aliè.

No cal que recorrem a la ciència ficció per endevinar els perills que poden derivar-se d’una implementació inadequada de la IA. Ja estem observant, avui dia, el que pot passar quan no hi ha un respecte majúscul per la privacitat o quan determinats algoritmes imposen biaixos inadequats en les recomanacions de certs programes. Estem a temps per evitar un món en el qual hàgim de patir els deliris de nous HAL9000.